アンサンブル学習:精度向上!複数のモデルを組み合わせる

機械学習におけるモデルの性能向上は、研究者や実践者の共通の目標です。ただし、単一のモデルでは限界があるため、複数のモデルを組み合わせるアンサンブル学習というアプローチが開発されました。アンサンブル学習では、異なるモデルを組み合わせることで、個々のモデルでは実現できない高精度を達成することができます。このアプローチの有効性は、各種のタスクにおいて実証されており、多くの研究者や実践者が注目しています。 本稿では、アンサンブル学習の基礎的な概念や、実際の活用方法を紹介します。

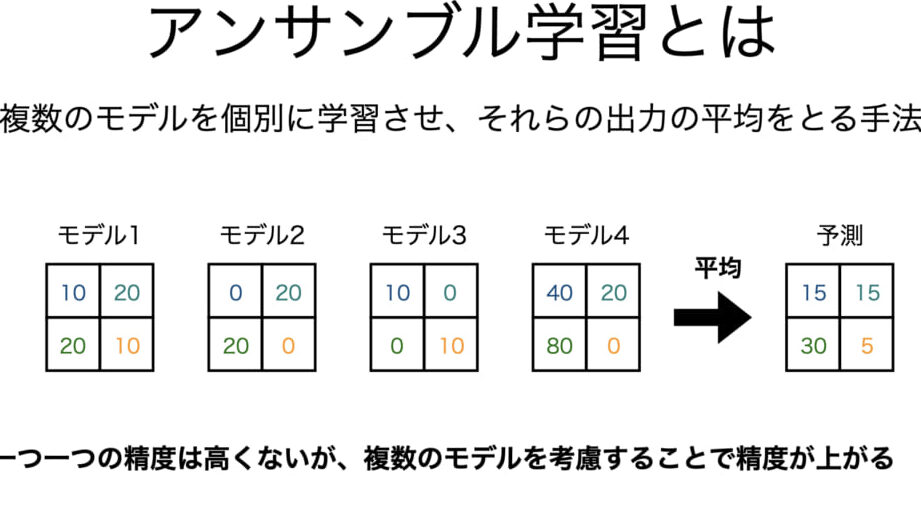

アンサンブル学習の真髄:複数のモデルを組み合わせることで高精度化を実現

アンサンブル学習は、機械学習の領域において、高精度化を実現するための有効的な手法の一つです。この手法では、複数のモデルを組み合わせることで、個々のモデルでは実現できなかった高精度化を実現できます。

アンサンブル学習の基本概念

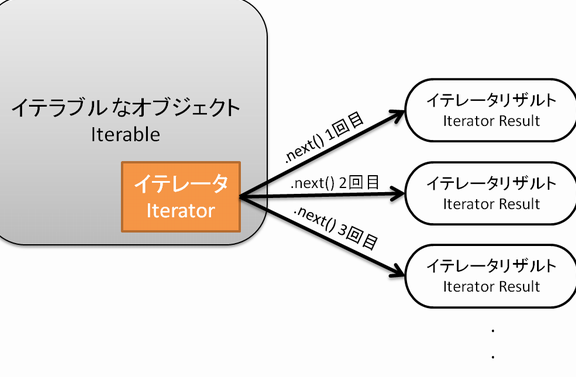

アンサンブル学習は、個々のモデルを組み合わせることで、予測性能を向上させることを目的としています。この手法では、各モデルは独立して予測を行い、最後に結果を組み合わせることで、最終的な予測結果を生成します。この過程で、個々のモデルにおける誤差を相殺することができます。

アンサンブル学習の種類

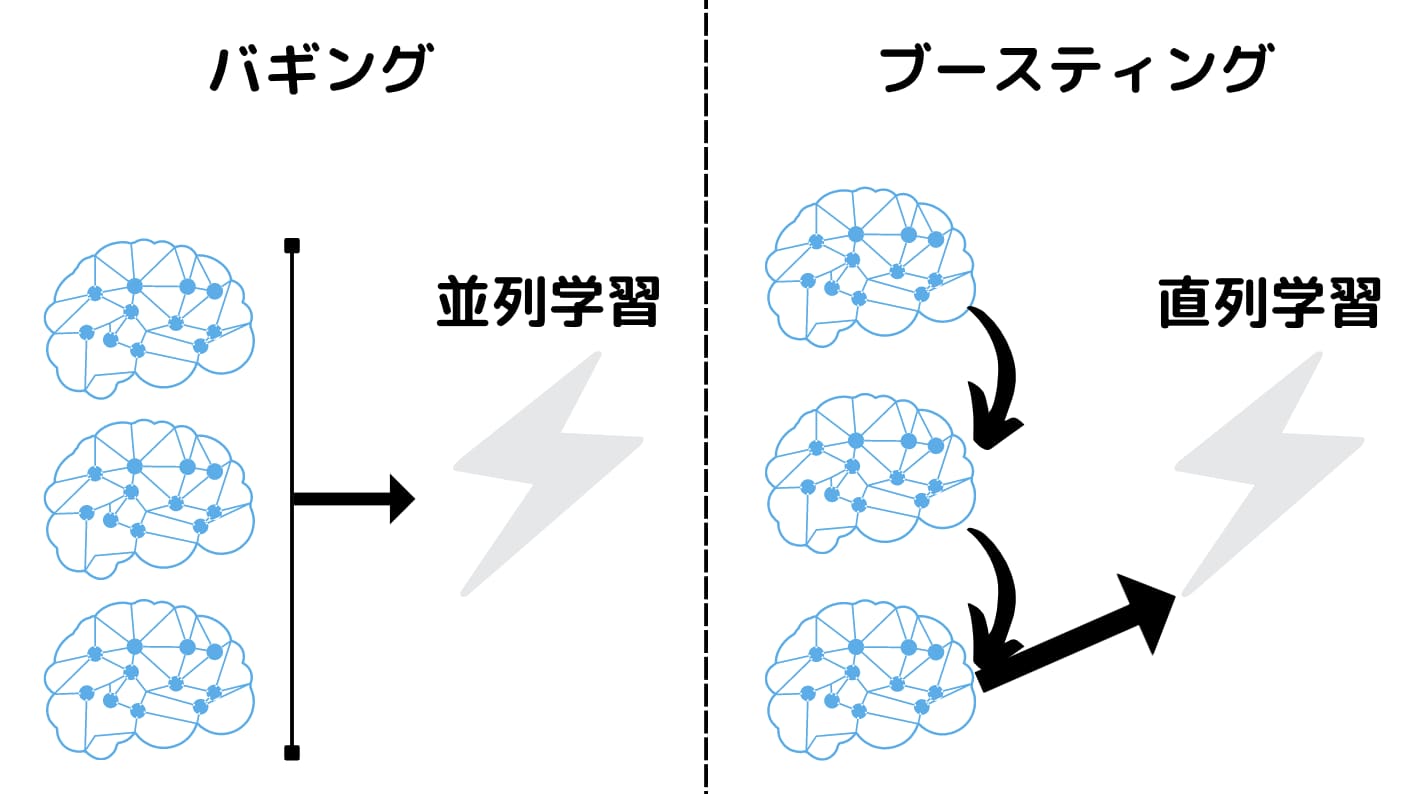

アンサンブル学習には、Bagging、Boosting、Stackingなど複数の種類があります。Baggingでは、複数のモデルをランダムサンプリングすることで、予測性能を向上させることを目的としています。一方、Boostingでは、各モデルを順番に学習させ、誤差を減らすことを目的としています。Stackingでは、複数のモデルを組み合わせることで、予測性能を向上させることを目的としています。

アンサンブル学習のメリット

アンサンブル学習には、複数のメリットがあります。高精度化を実現できること、汎化性能が向上すること、モデルへの依存を低減することができます。また、アンサンブル学習では、個々のモデルにおける誤差を相殺することができます。

イテレータとイテラブル:分割代入できない理由アンサンブル学習のデメリット

アンサンブル学習には、複数のデメリットがあります。計算コストが高くなること、過学習のおそれがあること、解釈性が低下することがあります。また、アンサンブル学習では、個々のモデルを適切に選択することが必要です。

アンサンブル学習の実際的な応用

アンサンブル学習は、実際的に多くの領域において応用されています。画像認識、自然言語処理、予測分析など、様々な分野において、高精度化を実現するためにアンサンブル学習が使用されています。

| アンサンブル学習の種類 | 説明 |

|---|---|

| Bagging | 複数のモデルをランダムサンプリングすることで、予測性能を向上させる |

| Boosting | 各モデルを順番に学習させ、誤差を減らす |

| Stacking | 複数のモデルを組み合わせることで、予測性能を向上させる |

複数のモデルを組み合わせて新たなモデルを作ること、あるいは予測することを何というか?

複数のモデルを組み合わせて新たなモデルを作ること、あるいは予測することを Ensemble Learning という。

アンサンブル学習の方法

アンサンブル学習には、 Bagging、Boosting、Stacking などの方法があります。

Excel VBA:CSVファイル出力!メモ- Bagging:複数のモデルを並列して学習し、平均や投票によって予測結果を決定する手法

- Boosting:複数のモデルを系列にして学習し、各モデルの予測結果を重みづけして決定する手法

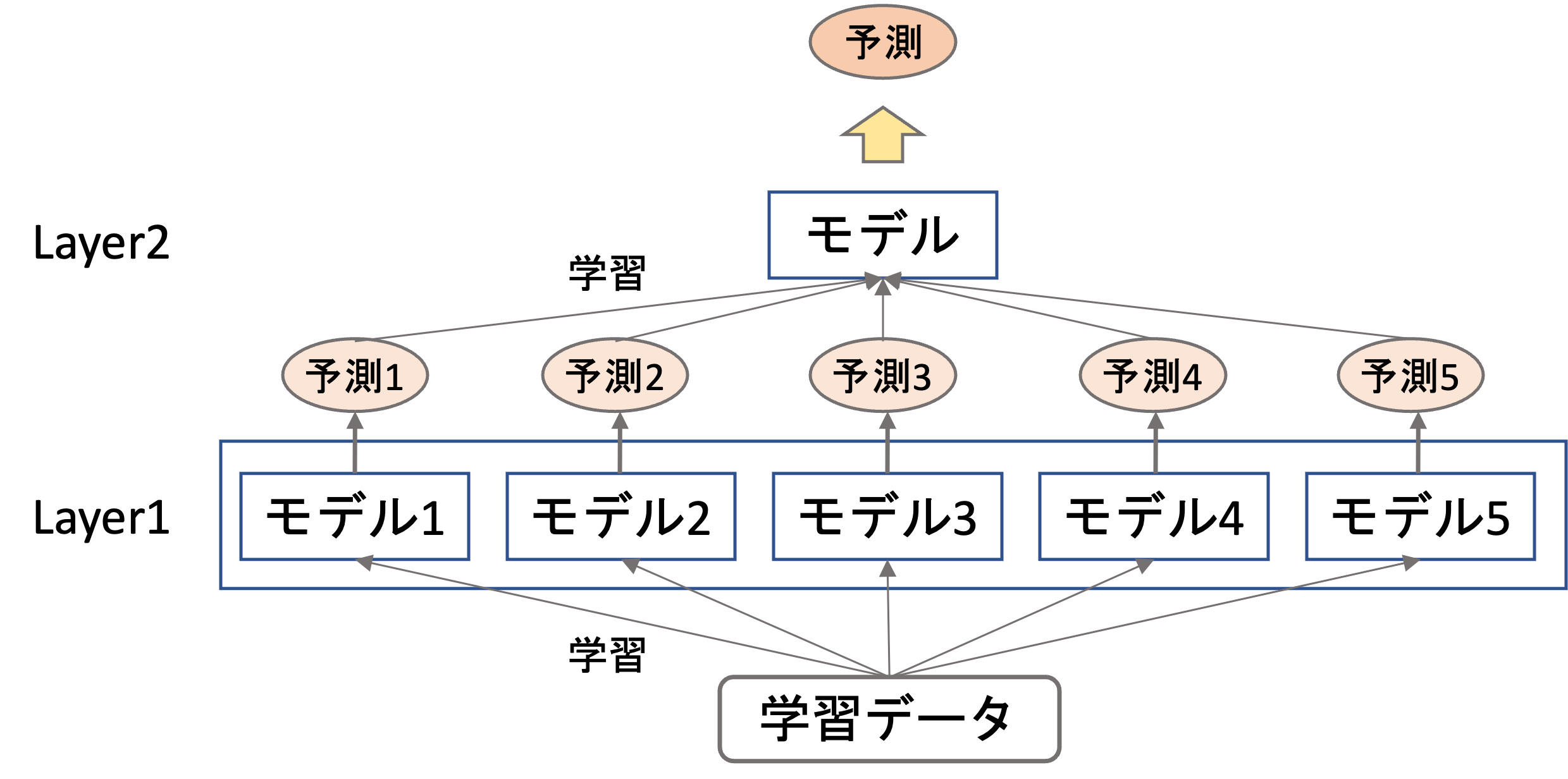

- Stacking:複数のモデルを組み合わせて、新しいモデルを学習し、そのモデルで予測結果を決定する手法

アンサンブル学習の利点

アンサンブル学習には、以下のような利点があります。

- 予測性能の向上:複数のモデルを組み合わせることで、予測性能が向上する

- 過学習の抑制:個々のモデルに過学習が生じることを抑制する

- 汎化性能の向上:複数のモデルを組み合わせることで、汎化性能が向上する

アンサンブル学習の実際的な活用例

アンサンブル学習は、以下のような実際的な問題に適用されています。

- 信用リスクの予測:複数のモデルの予測結果を組み合わせて、信用リスクを予測する

- 医療診断:複数のモデルを組み合わせて、医療診断の予測結果を決定する

- 株式予測:複数のモデルの予測結果を組み合わせて、株式の価格を予測する

複数の学習器を組み合わせた機械学習の手法を何と呼ぶか?

この手法は、アンサンブル学習(ensemble learning)と呼ばれます。これは、複数の学習器を組み合わせて、予測精度を向上させるための機械学習の手法です。

アンサンブル学習のメリット

アンサンブル学習のメリットとして、以下のような点が挙げられます。

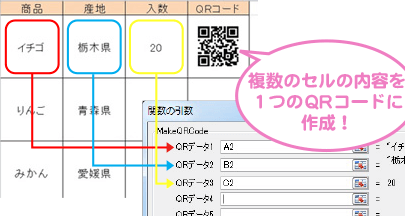

Excel:ワークシート関数でQRコード作成!- 予測精度の向上:複数の学習器を組み合わせることで、予測精度を向上させることができます。

- 汎化性能の向上:アンサンブル学習では、個々の学習器の弱点を補うことができます。

- 過学習の防止:複数の学習器を組み合わせることで、過学習の防止に役立ちます。

アンサンブル学習の手法

アンサンブル学習の手法として、以下のようなものがあります。

- バギング(bagging):複数の学習器を組み合わせることで、予測精度を向上させる手法です。

- ブースティング(boosting):弱い学習器を組み合わせることで、強い学習器を作成する手法です。

- スタッキング(stacking):複数の学習器を組み合わせることで、予測精度を向上させる手法です。

アンサンブル学習の実際の例

アンサンブル学習の実際の例として、以下のようなものがあります。

- 画像認識:複数の画像認識モデルを組み合わせることで、より高精度な画像認識を実現できます。

- 自然言語処理:複数の自然言語処理モデルを組み合わせることで、より高精度な文書分類や機械翻訳を実現できます。

- 推薦システム:複数の推薦モデルを組み合わせることで、より高精度な推薦を実現できます。

アンサンブル学習の欠点は何ですか?

COMPUTATIONAL COST

アンサンブル学習の1つの大きな欠点は、計算コストが高いことです。アンサンブル学習では、複数のモデルの予測結果を組み合わせて最適な予測結果を得るため、計算コストが منابعモデルよりも高くなります。このため、コンピューターの性能や計算リソースが不足している場合、アンサンブル学習を適用することが困難になります。

- 計算コストが高いと、計算時間が長くなります。

- 計算リソースが不足している場合、アンサンブル学習を適用することができません。

- コンピューター性能が低いと、計算時間が長くなります。

_override_

また、アンサンブル学習には、overrideの問題があります。overrideとは、複数のモデルの予測結果が互いに干渉して、最適な予測結果が得られないという問題です。この問題は、アンサンブル学習のパフォーマンスを低下させる要因となります。

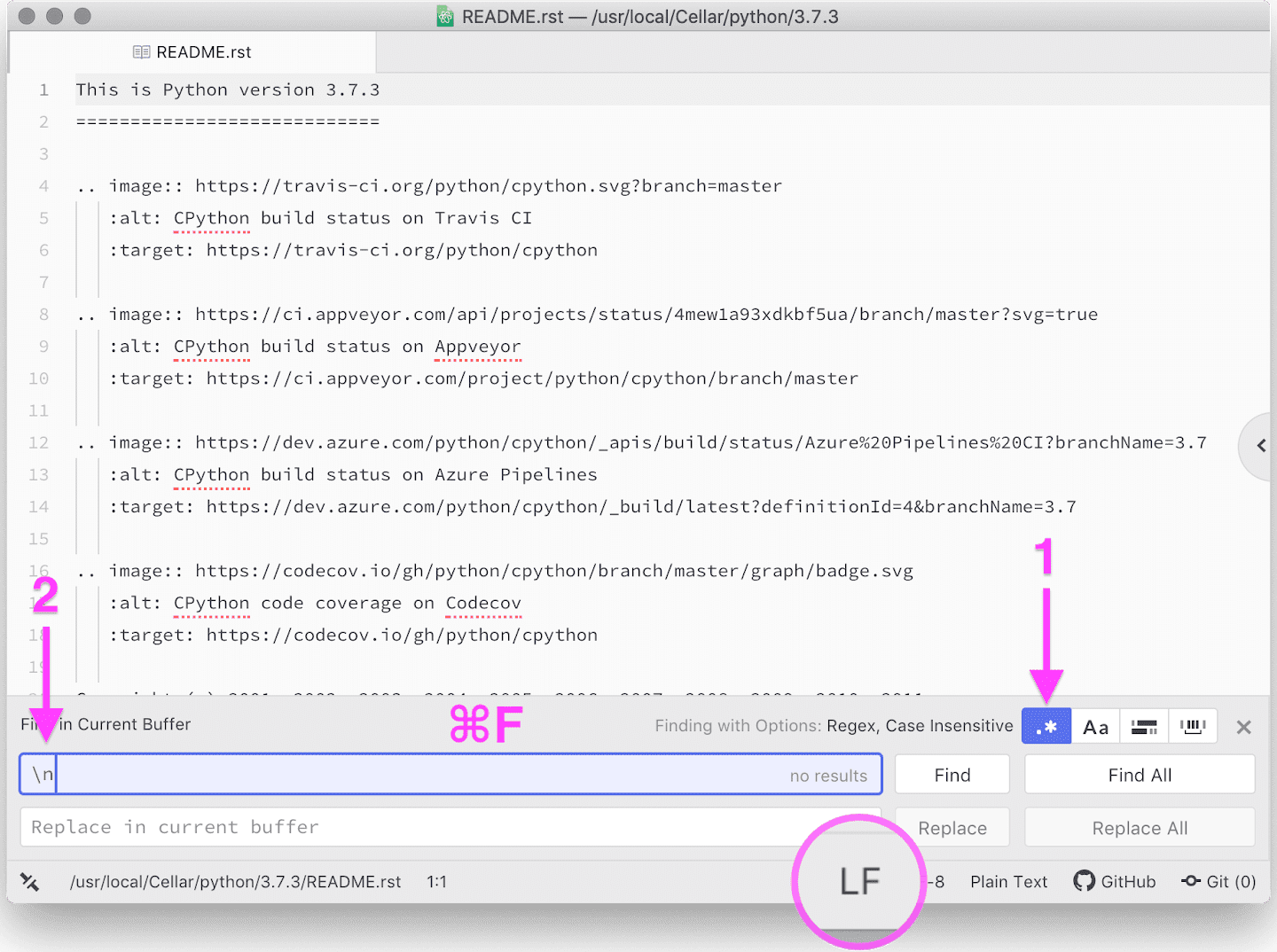

Atomエディタ:正規表現で文字を一括置換!- 複数のモデルの予測結果が互いに干渉します。

- 最適な予測結果が得られません。

- アンサンブル学習のパフォーマンスが低下します。

_diversity_

さらに、アンサンブル学習には、diversityの問題があります。diversityとは、複数のモデルの予測結果が似ているという問題です。この問題は、アンサンブル学習のパフォーマンスを低下させる要因となります。

- 複数のモデルの予測結果が似ています。

- アンサンブル学習のパフォーマンスが低下します。

- 異なるモデルの予測結果を組み合わせることができません。

アンサンブル学習のバギングとは?

アンサンブル学習のバギングとは、機械学習において、複数のモデルを組み合わせて予測結果を改善する手法のひとつである。バギングの目的は、個々のモデルが持つノイズやバイアスを平均化し、結果的に予測の正確さを高めることにある。

バギングのメリット

バギングのメリットとして、以下のような点が挙げられる。

- 予測の正確さを高めることができる。

- 個々のモデルのノイズやバイアスを減らすことができる。

- 複数のモデルの強みを合わせることができる。

バギングの種類

バギングには、以下のような種類がある。

エンジニアの3大原則:知っておくべき心構え- ブートストラップ・アグリゲーション:トレーニングデータをランダムサンプリングし、各サンプルに対して予測結果を取得、最終的には各予測結果を平均化する。

- バギング・リファレンス:各モデルの予測結果を個別に評価し、最良の予測結果を選択する。

- スタッキング:各モデルの予測結果をスタッキングし、最終的には予測結果を平均化する。

バギングのアプリケーション

バギングは、以下のようなアプリケーションで使用されている。

- 画像認識:複数の画像認識モデルを組み合わせて、予測の正確さを高める。

- 自然言語処理:複数の自然言語処理モデルを組み合わせて、予測の正確さを高める。

- 推薦システム:複数の推薦モデルを組み合わせて、予測の正確さを高める。

よくある質問

アンサンブル学習とは何か?

アンサンブル学習は、複数のモデルを組み合わせて予測性能を向上させる機械学習の手法です。多くのモデルを組み合わせることで、個々のモデルの弱点を補い、 GLOBAL な予測性能を向上させることができます。アンサンブル学習は、様々なタスクに適用可能で、画像認識、自然言語処理、予測モデルの性能向上などに効果的に利用されています。

アンサンブル学習のメリットは何か?

アンサンブル学習の最大のメリットは、予測性能の向上です。複数のモデルを組み合わせることで、個々のモデルの誤差を補い、 GLOBAL な予測性能を向上させることができます。また、アンサンブル学習により、過学習の防止や汎化性能の向上も期待できます。さらに、アンサンブル学習は、モデルを組み合わせることで柔軟性が高まり、様々なタスクに対応することができます。

アンサンブル学習の種類は何か?

アンサンブル学習には、バギング、ブーミング、スタッキングなどの種類があります。バギングは、複数のモデルを並列で学習させることで、予測性能を向上させる方法です。ブーミングは、複数のモデルを逐次的に学習させることで、予測性能を向上させる方法です。スタッキングは、複数のモデルの予測結果を組み合わせることで、予測性能を向上させる方法です。

アンサンブル学習を実現するには、何が必要ですか?

アンサンブル学習を実現するには、複数のモデルと大規模なデータセットが必要です。また、適切なアルゴリズムと計算リソースも必要です。加えて、アンサンブル学習では、モデルの選択やハイパーパラメーターのチューニングも重要です。適切なモデルの選択とパラメーターのチューニングを行うことで、アンサンブル学習の性能を最大化することができます。